ログ・ソースとのコネクタの作成

ログ・サービスからターゲット・サービスにログ・データを転送するためのコネクタ・ハブにコネクタを作成します。

ログ・サービスの詳細は、ロギングを参照してください。

ロギング・ソースおよびオプションのタスクで定義されたコネクタは、すべてのターゲットをサポートします。コネクタ・ハブ・ワークフローの例は、「コネクタ・ハブの概要」を参照してください。ソースとしてLoggingを使用し、Functionsタスクを使用するコネクタの例は、シナリオ: Autonomous Databaseへのログ・データの送信を参照してください。

保持期間: ロギング・ソース

コネクタ・ハブのロギング・ソースの保持期間は24時間です。搬送の詳細は、「搬送詳細」を参照してください。

新しいコネクタの最初の実行に成功すると、コネクタの作成時間からログ・データが移動されます。最初の実行が失敗した場合(ポリシーの欠落など)、解決後、コネクタはコネクタ作成時間または現在時刻の24時間前(いずれか遅い方)からログ・データを移動します。

後で実行するたびに、次のログ・データが移動されます。後の実行が失敗し、24時間の保存期間内に解決が発生した場合、コネクタは次のログ・データを移動します。後の実行が失敗し、24時間の保存期間外に解決が発生した場合、コネクタは最新のログ・データを移動し、失敗した実行と最新のログ・データの間に生成されたデータは配信されません。

問合せ参照

ソース・ログをフィルタ処理するためにサポートされている問合せを確認するには、コネクタ・ハブのログ問合せリファレンスを参照してください。

作成プロセスが開始され、その進行状況が表示されます。完了すると、コネクタの詳細ページが開きます。 ロギング・ソースを使用してコネクタを作成するには、oci sch service-connector createコマンドと必要なパラメータを使用します:

oci sch service-connector create --display-name "<display_name>" --compartment-id <compartment_OCID> --source [<logging_source_in_JSON>] --target [<target_in_JSON>]CLIコマンドのパラメータおよび値の完全なリストは、CLIコマンド・リファレンスを参照してください。

CreateServiceConnector操作を実行してコネクタを作成します。

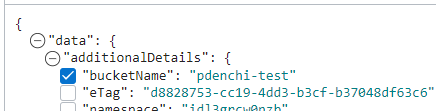

ロギング・ソースを含むコネクタを作成するには、リクエスト(CreateServiceConnectorDetails)の

sourceにロギングの詳細を移入します。例については、LoggingSourceDetailsを参照してください。