コネクタの作成

コネクター・ハブでコネクターを作成すること。

Oracle Cloud Infrastructureによる自動非アクティブ化を回避するには、ターゲット・サービスで予想される結果をチェックし、オプションでログを有効化して、コネクタがデータを正常に移動することを検証します。

このページには、コネクタを作成するための一般的な手順が示されています。

次のページでは、ソース固有の手順について説明します:

ソース・ログのフィルタリングでサポートされている問合せを確認するには、コネクタ・ハブのログ問合せリファレンスを参照してください。

- 「コネクタ」リスト・ページで、「コネクタの作成」を選択します。リスト・ページの検索に関するヘルプが必要な場合は、コネクタのリストを参照してください。

- 「コネクタの作成」ページで、新しいコネクタのわかりやすい名前と説明(オプション)を入力します。機密情報を入力しないでください。

- 新しいコネクタを格納するコンパートメントを選択します。

- 転送するデータを含むソース・サービスを選択します:

- 「ターゲット」で、データの転送先のサービスを選択します:

- (オプション)新しいコネクタのサービス・ログを有効にするには、「ログ」スイッチを選択し、次の値を指定します:

- ログ・カテゴリ: 値「コネクタ・トラッキング」が自動的に選択されます。

- コンパートメント: コネクタのサービス・ログを格納するコンパートメントを選択します。

- ログ・グループ: サービス・ログを格納するログ・グループを選択します。新しいログ・グループを作成するには、「新規グループの作成」を選択し、名前を入力します。

- ログ名: オプションで、ログの名前を入力します。

- 拡張オプションの表示:

- ログ保持: オプションで、サービス・ログを保持する期間を指定します(デフォルト: 30日)。

-

「ソース接続の構成」で、選択したソースの値を入力します。

- ロギング

-

- コンパートメント名: 必要なログを含むコンパートメント。

- ログ・グループ: 必要なログを含むログ・グループ。

ログ入力スキーマについては、LogEntryを参照してください。

- ログ: 必要なログ。このフィールドに表示されるログをフィルタするには、次のステップを参照してください。

- モニタリング

-

- メトリック・コンパートメント: 必要なメトリックを含むコンパートメントを選択します。

- ネームスペース: 必要なメトリックを含む1つ以上のメトリック・ネームスペースを選択します。選択したネームスペースのすべてのメトリックが取得されます。

ネームスペースは"

oci_"で始まる必要があります。例:oci_computeagent。 - 別のコンパートメントからメトリック・ネームスペースを追加するには、「+別のコンパートメント」を選択します。

Monitoringソース当たりのメトリック・コンパートメントの最大数は5です。(すべてのメトリック・コンパートメントにわたる)モニタリング・ソース当たりのネームスペースの最大数は50です。次に、この最大値内に残る単一ソース内のコンパートメント・セットの例を示します:

- それぞれ10個のネームスペースを持つ5つのメトリック・コンパートメント

- ネームスペースの数が異なる3つのメトリック・コンパートメント(20、20、10)

- 50ネームスペースの1つのメトリック・コンパートメント

- キュー

-

- コンパートメント: 必要なキューを含むコンパートメントを選択します。

- キュー: 必要なメッセージを含むキューを選択します。

-

チャネル・フィルタ(「メッセージ・フィルタリング」の下) (オプション): キュー内のチャネルからメッセージをフィルタするには、値を入力します。

たとえば、チャネルIDでメッセージをフィルタするには、チャネルIDを入力します。

サポートされている値については、GetMessages (キューAPI)の

channelFilterを参照してください。

ノート

コネクタのターゲットに転送されたメッセージは、「消費済」とみなされます。キュー・サービスの要件を満たすために、コネクタはソース・キューから転送されたメッセージを削除します。詳細は、メッセージの使用を参照してください。

- ストリーミング

-

- コンパートメント: 必要なストリームを含むコンパートメントを選択します。

- ストリーム・プール: 必要なストリームを含むストリーム・プールを選択します。

- ストリーム: データを受信するストリームの名前を選択します。

- 読取り位置: ストリームの読取りを開始するカーソル位置を指定します。

- Latest: コネクタの作成後に公開されたメッセージの読取りを開始します。

- この構成で新しいコネクタを初めて実行すると、コネクタの作成時間からデータが移動します。最初の実行が失敗した場合(ポリシーが欠落している場合など)、解決後、コネクタはコネクタの作成時間からデータを移動するか、作成時間が保存期間外の場合はストリーム内で使用可能な最も古いデータを移動します。たとえば、保存期間が2時間のストリームについて午前10時に作成されたコネクタを考えてみます。失敗した実行が午前11時に解決された場合、コネクタは午前10時からデータを移動します。失敗した実行が午後1時に解決された場合、コネクタはストリーム内で使用可能な最も古いデータを移動します。

- その後、ストリームの次の位置からデータを移動します。後で実行が失敗した場合、解決後、コネクタはストリームの次の位置またはストリーム内の最も古い使用可能なデータから、ストリームの保存期間に応じてデータを移動します。

- トリム範囲: ストリーム内で使用可能な最も古いメッセージから読取りを開始します。

- この構成で新しいコネクタを初めて実行すると、ストリーム内で使用可能な最も古いデータからデータが移動します。最初の実行が失敗した場合(ポリシーの欠落など)、解決後、コネクタはストリームの保存期間に関係なく、ストリーム内で使用可能な最も古いデータを移動します。

- その後、ストリームの次の位置からデータを移動します。後で実行が失敗した場合、解決後、コネクタはストリームの次の位置またはストリーム内の最も古い使用可能なデータから、ストリームの保存期間に応じてデータを移動します。

- Latest: コネクタの作成後に公開されたメッセージの読取りを開始します。

- (オプション)「ログ・フィルタ・タスク」(「ロギング」ソースで使用可能)で、ログをフィルタする値を入力します。

監査ログ(_Audit)の属性値を指定するには:

- フィルタ・タイプ: 「属性」を選択します。

- 属性名: 必要な監査ログ属性を選択します。

- 属性値: 選択した監査ログ属性の値を指定します。

監査ログ(_Audit)のイベントを指定するには:

- フィルタ・タイプ: 「イベント・タイプ」を選択します。

- サービス名: 目的のイベントを含むサービスを選択します。

- イベント・タイプ: 必要なイベントを選択します。

サービス・ログまたはカスタム・ログ(_Auditではない)のプロパティ値を指定するには:

- プロパティ: 目的のプロパティを選択します。

- 演算子: プロパティ値のフィルタリングに使用する演算子を選択します。

- 値: 必要なプロパティ値を指定します。

ソース・ログをフィルタリングするためにサポートされている問合せを確認するには、コネクタ・ハブのログ問合せリファレンスを参照してください。

- (オプション)「ファンクション・タスクの構成」で、ファンクション・サービスを使用してソースからのデータを処理するファンクション・タスクを構成します:

- タスクの選択: 「関数」を選択します。

- コンパートメント: 必要なファンクションを含むコンパートメントを選択します。

- ファンクション・アプリケーション: 必要なファンクションが含まれるファンクション・アプリケーションの名前を選択します。

- ファンクション: ソースから取得したデータの処理に使用するファンクションの名前を選択します。

タスクとしてコネクタによって使用される場合は、次のいずれかのレスポンスを返すようにファンクションを構成する必要があります:

- JSONエントリのリスト(レスポンス・ヘッダー

Content-Type=application/jsonを設定する必要があります) - 単一のJSONエントリ(レスポンス・ヘッダー

Content-Type=application/jsonを設定する必要があります) - 単一のバイナリ・オブジェクト(レスポンス・ヘッダー

Content-Type=application/octet-streamを設定する必要があります)

- JSONエントリのリスト(レスポンス・ヘッダー

- 追加オプションの表示: このリンクを選択し、ファンクションに送信されるデータのバッチごとに制限を指定します。手動設定を使用するには、バッチ・サイズ制限(KB)およびバッチ時間制限(秒)の値を指定します。

ファンクション・タスクの考慮事項:

- コネクタ・ハブは、ファンクション・タスクの出力を分析しません。ファンクション・タスクの出力は、そのままターゲットに書き込まれます。たとえば、ファンクション・タスクで通知ターゲットを使用する場合、すべてのメッセージはRAW JSON BLOBとして送信されます。

- ファンクションは、1回の呼出しで6MBのデータと同期するように呼び出されます。データが6MBを超えると、コネクタが再びファンクションを呼び出して制限を超えるデータを移動します。このような呼出しは順次処理されます。

- ファンクションは最大5分間実行できます。Delivery Detailsを参照してください。

- 関数タスクはスカラー関数に制限されます。

-

ターゲットとして「ファンクション」を選択した場合は、「ターゲットの構成」で、ログ・データの送信先となるファンクションを構成します。ステップ17にスキップします。

- コンパートメント: 必要なファンクションを含むコンパートメントを選択します。

- ファンクション・アプリケーション: 必要なファンクションを含むファンクション・アプリケーションの名前を選択します。

- ファンクション: データの送信先のファンクションの名前を選択します。

- 追加オプションの表示: このリンクを選択し、ファンクションに送信されるデータのバッチごとに制限を指定します。手動設定を使用するには、バッチ・サイズ制限(KBまたはメッセージ数)およびバッチ時間制限(秒)の値を指定します。

たとえば、5,000KBまたは10メッセージを選択して、バッチ・サイズを制限します。バッチ時間制限の例は5秒です。

ファンクション・ターゲットの考慮事項:

- コネクタはソース・データをJSONリストとしてバッチでフラッシュします。最大バッチ(ペイロード)サイズは6MBです。

- ファンクションは、1回の呼出しで6MBのデータと同期するように呼び出されます。データが6MBを超えると、コネクタが再びファンクションを呼び出して制限を超えるデータを移動します。このような呼出しは順次処理されます。

- ファンクションは最大5分間実行できます。Delivery Detailsを参照してください。

- ファンクション・ターゲットからコネクタにデータを返さないでください。コネクタ・ハブは、ファンクション・ターゲットから返されたデータを読み取りません。

- ターゲットとして「ログ・アナリティクス」を選択した場合は、「ターゲットの構成」で、ログ・データを送信するログ・グループを構成します。ステップ17にスキップします。

-

ターゲットとして「モニタリング」を選択した場合は、「ターゲットの構成」で、ログ・データを送信するメトリックを構成します。ステップ17にスキップします。

- コンパートメント: 必要なメトリックを含むコンパートメントを選択します。

- メトリック・ネームスペース: 必要なメトリックが含まれるメトリック・ネームスペースを選択します。既存のネームスペースを選択するか、新しいネームスペースを入力できます。

新しいネームスペースを入力したら、[Enter]を押して送信します。

新しいメトリック・ネームスペースの場合は、予約済

oci_接頭辞を使用しないでください。予約済プリフィクスが使用されると、メトリックが取得されません。カスタム・メトリックの公開およびPostMetricDataリファレンス(API)を参照してください。 - メトリック: データの送信先のメトリックの名前を選択します。既存のメトリックを選択するか、新しいメトリックを入力できます。

新しいメトリック名を入力したら、[Enter]を押して送信します。

新しいメトリックの場合は、予約済

oci_接頭辞を使用しないでください。予約済プリフィクスが使用されると、メトリックが取得されません。カスタム・メトリックの公開およびPostMetricDataリファレンス(API)を参照してください。 -

ディメンションの追加: オプションでディメンションを構成するには、このボタンを選択します。「ディメンションの追加」パネルが開きます。

ログ・データの最新の6行が、「ソースの構成」で指定されたログから取得されます。

データの送信先ディメンションごとに、名前と値のキー・ペアを指定します。名前はカスタムにすることができます。また、値は静的にするか評価対象のパスにすることができます。ディメンションを使用して、ログ・データがメトリックに移動された後にデータをフィルタ処理します。ディメンションのユースケースの例は、シナリオ: モニタリング・ターゲットのディメンションの作成を参照してください。

データ(パス値)を抽出するには-

「パスの選択」で、必要なログの下矢印を選択します。

拡張ログのパスがリストされます。

-

目的のパスのチェックボックスを選択します。

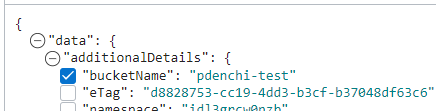

次の図は、選択したパス(

bucketName)および選択していないパス(eTag)の例を示しています。

「パスの編集」では、「ディメンション名」および「値」フィールドは、選択したパスから自動的に移入されます。

使用可能なログ・データがない場合は、「パスの編集」の下にカスタム・ディメンション名を含むパス値を手動で入力できます。パスはlogContentから開始し、ドット(.)またはインデックス([])表記のいずれかを使用する必要があります。ドットとインデックスはサポートされている唯一のJMESPathセレクタです。たとえば:logContent.data(ドット表記法)logContent.data[0].content(インデックス表記法)

有効なパス表記法の詳細は、JmesPathDimensionValueを参照してください。

- オプションで、ディメンション名を編集します。

データにタグ付けするには(静的値)

-

「静的値」で、「+別の静的値」を選択し、ディメンション名と値を入力します。たとえば、

trafficおよびcustomerを入力します。

-

ノート

新しい(カスタム)メトリックの場合、コネクタがソースからモニタリング・サービスにデータを初めて移動するときに、指定されたメトリック・ネームスペースおよびメトリックが作成されます。移動されたデータが存在するかどうかを確認するには、コンソール、CLIまたはAPIを使用して新しいメトリックを問い合せます。カスタム・メトリックの問合せの作成を参照してください。メトリックに含まれるもの

「ディメンションの構成」で指定したディメンションの名前と値のキー・ペアに加え、次のディメンションがメトリックに含まれます:connectorId: メトリックが適用されるコネクタのOCID。connectorName: メトリックが適用されるコネクタの名前。connectorSourceType: メトリックが適用されるソース・サービス。

各メトリック・データ・ポイントのタイムスタンプは、対応するログ・メッセージのタイムスタンプです。

-

ターゲットとして「通知」を選択した場合は、「ターゲットの構成」で、ログ・データの送信先となるトピックを構成します。ステップ17にスキップします。

- コンパートメント: 目的のトピックを含むコンパートメントを選択します。

- トピック: データの送信先のトピックの名前を選択します。

- メッセージ形式: 必要なオプションを選択します:ノート

「メッセージの書式」オプションは、ロギング・ソースのコネクタでのみ使用できます。これらのオプションは、ファンクション・タスクがあるコネクタでは使用できません。「メッセージ形式」オプションが使用できない場合、メッセージはRAW JSON BLOBとして送信されます。- フォーマットされたメッセージの送信: 簡単でわかりやすいレイアウト。

フォーマットされたメッセージに対してサポートされているサブスクリプション・プロトコルとメッセージ・タイプを確認するには、わかりやすいフォーマットを参照してください。

- RAWメッセージの送信: RAW JSON BLOB。

- フォーマットされたメッセージの送信: 簡単でわかりやすいレイアウト。

通知ターゲットの考慮事項:

- Notificationsターゲットの最大メッセージ・サイズは128KBです。最大サイズを超えるメッセージは削除されます。

- SMSメッセージでは、特定のコネクタ構成の場合に予期しない結果が生成されます。この問題は、指定されたコネクタ構成でSMSサブスクリプションを含むトピックに限定されます。詳細は、1つの通知に対する複数のSMSメッセージを参照してください。

-

ターゲットとして「オブジェクト・ストレージ」を選択した場合は、「ターゲットの構成」で、ログ・データの送信先となるバケットを構成します。ステップ17にスキップします。

- コンパートメント: 目的のバケットを含むコンパートメントを選択します。

- バケット: データの送信先のバケットの名前を選択します。

- オブジェクト名の接頭辞: オプションで、接頭辞値を入力します。

- 追加オプションの表示: このリンクを選択し、オプションでバッチ・サイズ(MB)およびバッチ時間(ミリ秒)の値を入力します。

オブジェクト・ストレージ・ターゲットに関する考慮事項:

-

バッチ・ロールオーバーの詳細:

- バッチ・ロールオーバー・サイズ: 100MB

- バッチ・ロールオーバー時間: 7分

-

オブジェクト・ストレージに保存されるファイルは、gzipを使用して圧縮されます。

-

モニタリング・ソースから移動されたデータの形式: オブジェクト。コネクタは、メトリック・ネームスペース別のモニタリングからソース・データをパーティション化し、各グループ(ネームスペース)のデータをオブジェクトに書き込みます。各オブジェクト名には次の要素が含まれます。

<object_name_prefix>/<service_connector_ocid>/<metric_compartment_ocid>/<metric_namespace>/<data_start_timestamp>_<data_end_timestamp>.<sequence_number>.<file_type>.gzオブジェクト内では、データ・ポイントの各セットが新しい行に追加されます。

-

ターゲットとして「ストリーミング」を選択した場合は、「ターゲットの構成」で、ログ・データの送信先となるストリームを構成します。

ノート

コネクタのストリーム・プールおよびストリームを選択するには、ストリーム・プールおよびストリームを読み取るための認可が必要です。IAMポリシー(コネクタ・ハブの保護)を参照してください。プライベート・エンドポイント構成がサポートされています。プライベート・エンドポイントを使用するには、Streamsのプライベート・エンドポイントの前提条件を参照してください。- コンパートメント: 必要なストリームを含むコンパートメントを選択します。

- ストリーム: データの送信先のストリームの名前を選択します。

ストリーミング・ターゲットの考慮事項:

- Monitoringソースから移動されるデータの形式: 各オブジェクトは個別のメッセージとして書き込まれます。

-

デフォルト・ポリシーを受け入れるには、各デフォルト・ポリシーに用意されている「作成」リンクを選択します。

デフォルト・ポリシーは、このコネクタがソース、タスクおよびターゲット・サービスにアクセスするために必要な認可のために提供されます。

この認可は、このようなデフォルト・ポリシーまたはグループベースのポリシーから取得できます。デフォルト・ポリシーは、コンソールを使用してコネクタを作成または編集する際に必ず提供されます。唯一の例外は、IAMに正確なポリシーがすでに存在する場合です。このケースではデフォルト・ポリシーは提供されません。この認可要件の詳細は、認証と認可を参照してください。

- デフォルト・ポリシーを受け入れる権限がない場合は、管理者に連絡してください。

- 自動的に作成されたポリシーは、コネクタが削除されてもそのままです。ベスト・プラクティスとしては、コネクタを削除するときに関連するポリシーを削除してください。

新しく作成したポリシーを確認するには、関連付けられたビュー・リンクを選択します。

- (オプション)コネクタに1つ以上のタグを追加します: 「拡張オプションの表示」を選択して、「タグの追加」セクションを表示します。

リソースを作成する権限がある場合、フリーフォーム・タグをそのリソースに適用する権限もあります。definedタグを適用するには、タグnamespaceを使用する権限が必要です。タグ付けの詳細は、リソース・タグを参照してください。タグを適用するかどうかがわからない場合は、このオプションをスキップするか、管理者に問い合せてください。タグは後で適用できます。

- 「作成」を選択します。

作成プロセスが開始され、その進行状況が表示されます。完了すると、コネクタの詳細ページが開きます。 oci sch service-connector createコマンドおよび必須パラメータを使用して、コネクタを作成します:

oci sch service-connector create --display-name "<display_name>" --compartment-id <compartment_OCID> --source [<source_in_JSON>] --target [<target_in_JSON>]CLIコマンドのパラメータおよび値の完全なリストは、CLIコマンド・リファレンスを参照してください。

CreateServiceConnector操作を実行してコネクタを作成します。

新規コネクタによるデータの移動の確認

コネクタを作成したら、データが移動していることを確認します。

- コネクタでデータ・フローの詳細を取得するためのログの有効化。

- ターゲット・サービスで予想される結果を確認します。

データが移動されていることを確認すると、自動非アクティブ化を回避できます。これは、コネクタに長時間障害が発生した場合に発生します。

プライベート・ストリーム: プライベート・エンドポイントを含むストリームを使用するように既存のコネクタを改装することはできません。ストリーム・ソースまたはターゲットに選択したストリーム・プールがパブリックの場合、プライベートに変更できず、プライベート・ストリームを参照するようにコネクタを更新できません。別のプライベート・ストリームを使用するようにソースまたはターゲットを変更するか、ストリーミング以外のソースまたはターゲットを使用するには、必要なソースおよびターゲットでコネクタを再作成します。別のプライベートストリームの必要性の例として、別のストリームプールに移動されたストリームがあります。その場合は、移動したストリームを使用してコネクタを再作成します。必要のないストリーム・ソースまたはターゲットを持つ古いコネクタを非アクティブ化または削除してください。