データ・フローを使用したデータの収集および変換

データ・フローは、データベースやフラット・ファイルなどのソース・データ・アセットからデータ・レイクやデータ・ウェアハウスなどのターゲット・データ・アセットへのデータのフローを表す論理ダイアグラムです。

ソースからターゲットへのデータのフローで、データを集計、クレンジングおよび整形するための一連の変換を実行できます。これにより、データ・エンジニアおよびETL開発者は、インサイトを分析または収集し、そのデータを使用してビジネス上の大きな意思決定を下せるようになります。

このチュートリアルでは:

- データ・フローを保存できるプロジェクトを作成します。

- ソース演算子を追加し、データ・フローで使用するデータ・エンティティを選択します。

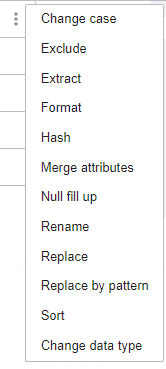

- 整形演算子を使用し、変換を適用します。

- データをロードするためのターゲット・データ・アセットを識別します。

開始する前に

データ・フローを使用してデータを収集および変換するには、次のものが必要です:

- データ統合ワークスペースへのアクセス権。データ統合への接続を参照してください。

- 作成されたソース・データ・アセットおよびターゲット・データ・アセット。

-

ステージング・バケットで有効になっている

PAR_MANAGE権限。allow any-user to manage buckets in compartment <compartment-name> where ALL {request.principal.type = 'disworkspace', request.principal.id = '<workspace-ocid>', request.permission = 'PAR_MANAGE'}自律型データベースは、データのステージングにオブジェクト・ストレージを使用し、事前認証済リクエストが必要です。

1. プロジェクトおよびデータ・フローの作成

Oracle Cloud Infrastructure Data Integrationでは、データ・フローおよびタスクはプロジェクトまたはフォルダ内にのみ作成できます。

プロジェクトおよびデータ・フローを作成するには:

2. ソース演算子の追加

ソース演算子を追加して、データ・フローに使用するデータ・エンティティを識別します。このチュートリアルでは、データ・エンティティはデータベース表を表します。

演算子の詳細を参照してください。

3. データのフィルタリングおよび変換

フィルタ演算子は、条件に基づいてアップストリーム演算子からデータのサブセットを生成します。

データ・エクスプローラを使用すると、データ・サンプルを探索したり、プロファイリング・メタデータを確認したり、「プロパティ」パネルの「データ」タブで変換を適用することができます。変換が適用されるたびに、式演算子がキャンバスに追加されます。

4. データの結合

フィルタおよび変換を適用した後は、一意の顧客識別子を使用してソース・データ・エンティティを結合してから、データをターゲット・データ・エンティティにロードできます。

5. ターゲット演算子の追加

その他のリソース

さらに学習するには、次のURLを参照してください。

次の手順

データ・フローを使用してデータを収集および変換した後は、データ・フローを構成および実行するための統合タスクを作成する必要があります。

)

)